最近Deepseek经常无响应,使用人数很多,那有没有办法解决这个问题呢?

有2个方法:

1.本地部署

2.对接api (付费)

今天就通过3个步骤,教会大家在本地部署Deepseek大模型,就算不联网也可以使用。跟着我的步骤做小白也能轻松上手,避免找不到,请大家收藏本网站。

Deepseek 本地部署硬件要求根据模型大小不同而有所差异,以下是DeepSeek本地部署的硬件要求表格:

| 模型版本 | CPU | 内存 | 显卡 | 存储 | 网络 |

| DeepSeek-R1-1.5B | 任意四核处理器 | 8GB | 无需GPU | 12GB | 本地部署无需高带宽,云端需≥100Mbps |

| DeepSeek-R1-7B | Ryzen 7或更高 | 16GB | RTX 3060(12GB)或更高 | 80GB | 本地部署无需高带宽,云端需≥100Mbps |

| DeepSeek-R1-14B | i9-13900K或更高 | 32GB | RTX 4090(24GB)或更高 | 200GB | 本地部署无需高带宽,云端需≥100Mbps |

| DeepSeek-R1-32B | Xeon 8核+128GB或更高 | 64GB | 2-4张A100 80GB或更高 | 320GB | 多卡需PCIe 4.0互联,云端部署建议≥1Gbps带宽 |

| DeepSeek-R1-70B | Xeon 8核+128GB或更高 | 128GB | 8+张A100/H100,显存≥80GB/卡 | 500GB+ | NVIDIA NVLink/InfiniBand(≥200Gbps)互联 |

从这个表格中我们可以发现,个人用户,最适合的是DeepSeek-R1-7B模型,既能满足大多数日常需求,同时硬件条件又是大部分电脑的水平,今天我主要带大家去部署这个模型。

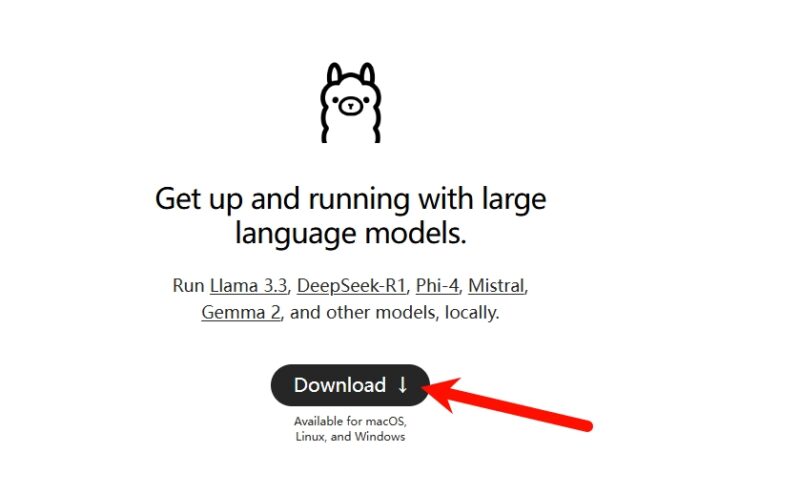

第一步 下载Ollama

Ollama 是一个开源的本地化大模型部署工具,能够简化大语言模型(LLM)的安装、运行和管理。

1.访问Ollama官网:https://ollama.com/ 下载

百度网盘下载:https://pan.baidu.com/s/1kRutw45ABuO7auOGcov4kA?pwd=umgi

![图片[1]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/03.jpg)

根据你的操作系统选择对应的安装包进行下载。我个人是Window11的

![图片[2]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/16.jpg)

下载完成后,双击安装包进行安装,按照提示完成安装过程。

如何安装到D盘:ollama自定义安装路径,安装到D盘方法 – 杨振轩笔记

2.安装完成Ollama 后我们打开cmd命令窗口(快捷键win+R,输入“cmd”按回车)

输入ollama 按回车,如果显示和下图一样表示安装成功

![图片[3]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/07.jpg)

3.下载模型

回到 Ollama 网站上,点击左上角的“Models” 按钮

![图片[4]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/image.png)

在搜索栏上输入“DeepSeek”搜索,找到DeepSeek-r1直接进入

![图片[5]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/P45.jpg)

选择7b模型,让后点击右边的复制按钮

![图片[6]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/028aab087e8b5d186bc49a265c7e60e3.png)

回到cmd界面,将刚刚复制的代码粘贴+回车,

![图片[7]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/cc5b745861a6e4126994ed806a26d194.png)

等待模型下载完

![图片[8]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/f7862d863f99755fcf0afb16c18c8c39.png)

这里出现“success”表示下载完成

![图片[9]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/9880d528bc15247e05af8e6b2360b66f.png)

第三步 安装chatboxai

chatboxai是一个大模型的可视化工具,帮你创建一个直接和大模型对话的窗口

下载地址:https://chatboxai.app/zh

![图片[10]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/081e45682069ccfa001ea8859b709176.png)

下载安装完成后,需要进行模型添加

![图片[11]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/ff1512fecdae7bdbdacf484956172ae4.png)

如下图操作配置:

![图片[12]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/9cad3fe22b79e795a73428c0144a0ac2.png)

本地部署完成,可以尽情使用了

![图片[13]-图解教程|5分钟完成Deepseek本地部署-杨振轩笔记](https://yem569.com/wp-content/uploads/2023/05/c0a02f35362a762625d3393a42bee424-1019x1080.png)

好了,以上就是用DeepSeek本地部署的全部流程了

是不是非常简单,赶紧试试吧,有任何问题欢迎留言

暂无评论内容